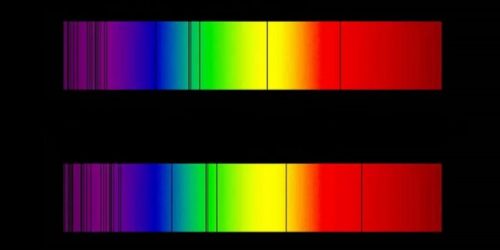

Ik begon mijn Astroblog gisteren over de verschillende metingen aan de uitdijing van het heelal met de zin “Sinds de waarnemingen van Vesto Slipher en Edwin Hubble in de jaren twintig van de vorige eeuw aan de roodverschuiving van sterrenstelsels weten we dat het heelal uitdijt.” Met recht zou je de vraag kunnen stellen “Oh ja, is dat zo? Is die roodverschuiving van sterrenstelsels een indicatie voor de uitdijing van het heelal?” Dát de meeste sterrenstelsels in het heelal in hun spectrum een roodverschuiving van spectraallijnen laten zien staat buiten kijf, da’s gewoon een feit. Maar komt dat echt doordat het heelal uitdijt en het licht van die stelsels daardoor naar de rode kant van het spectrum opschuift? Of zou het misschien door een andere oorzaak komen? Zou het misschien komen doordat het licht door een bepaalde oorzaak zelf energie verliest, bijvoorbeeld doordat de fotonen onderweg naar aarde energie verliezen door botsingen met intergalactisch gas of dat fotonen spontaan energie verliezen? Die theorie wordt de theorie van het vermoeide licht genoemd (Engels: ’tired light’) en hij is al in 1929 voorgesteld door Fritz Zwicky, de man die enkele jaren later ook als één van de eersten met het bestaan van donkere materie aankwam.

In 2013 werden zes kosmologische modellen onderworpen aan een observationele test, de zogeheten Alcock-Paczynski test, en daaruit kwam naar voren dat maar twee modellen voldeden aan de test: het ΛCDM model – hét gangbare heelalmodel, met een mix van donkere energie (Λ) en koude, donkere materie (CDM), én het vermoeid licht model. Aha, dan zou je toch denken dat het laatste model wel wat meer aandacht mag hebben? Yep, dat zou zo zijn, ware het niet dat door andere waarnemingen ook het vermoeid licht model door de mand valt en het ΛCDM model als enige overblijft. De argumenten op een rijtje waarom het vermoeid licht model niet juist is, ondanks de Alcock-Paczynski test:

- als licht energie verliest door botsingen met gas en stof onderweg naar de aarde moet dat ook leiden tot verandering van impulsmoment van de fotonen, de lichtdeeltjes. Hoe verder weg een sterrenstelsel staat hoe meer verandering van impulsmoment van de fotonen van dat stelsel zal geven en dat zal op foto’s zichtbaar moeten zijn in een vervaging van de sterrenstelsels. Die vervaging (Engels: ‘blurring’) is echter niet waargenomen, sterrenstelsels ver weg zijn net zo scherp als stelsels dichtbij, alleen is hun lichtkracht minder.

- in een heelal met vermoeid licht zou er geen tijddilatatie moeten zijn in de lichtcurve van type Ia supernovae. In zo’n model zou een supernova bijvoorbeeld altijd in 20 dagen een verval in lichtkracht van een bepaald percentage moeten vertonen, ongeacht de afstand. De werkelijkheid is echter dat er tijddilatatie is waargenomen, in overeenstemming met het ΛCDM model. Supernovae met een roodverschuiving z=1 hebben bijvoorbeeld een verval nodig van 40 dagen, terwijl dat voor supernovae dichtbij 20 dagen is.

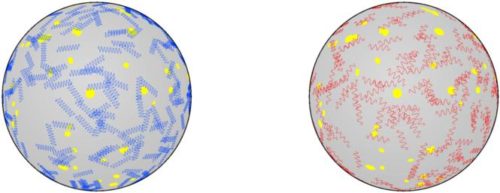

- het vermoeid lichtmodel geeft een andere voorspelling voor de intensiteit van de kosmische microgolf-achtergrondstraling als waargenomen. Zie bijvoorbeeld de grafiek hieronder, waarin de rode lijn de voorspelling en de geblokte lijn de waarneming.

- Tenslotte overtreedt het vermoeid licht model, waarbij fotonen feitelijk spontaan energie verliezen en daardoor naar het rood verschuiven, een belangrijke natuurwet, namelijk de wet van behoud van energie.

En zodoende kan ik met een gerust hart beweren dat we sinds de waarnemingen van Vesto Slipher en Edwin Hubble in de jaren twintig van de vorige eeuw aan de roodverschuiving van sterrenstelsels weten dat het heelal uitdijt. Maar betekent dat ook dat we het ΛCDM model klakkeloos moeten accepteren en dat andere modellen hebben afgedaan? Nee zeker niet, ook het ΛCDM model is vatbaar voor verbetering en fine-tuning, zeker als we verschillende gemeten waarden tegenkomen van de constante van Hubble, zoals ik gisteren schreef. Alle modellen zullen op de pijnbank moeten worden gelegd van toetsing aan de waarnemingen en als ze daar niet aan kunnen voldoen vallen ze af of moeten ze worden verbeterd. Bron: UCLA + Koberlein.

Tsja, het Sunyaev-Zel’dovich effect is inderdaad een lastige.

Aan de andere kant vind ik de gedachte dat er géen botsingen plaatsvinden onderweg naar de aarde, net zo ondenkbaar.

Een ander optie gaat al een tijdje rond:

http://phys.org/news/2011-10-supernovae-universe-expansion-understood-dark.html

Mies

Over het SZ-effect: dat heeft toch alleen betrekking op de kosmische microgolf-achtergrondstraling, toch niet op het licht van sterrenstelsels? Ja, je zou verwachten dat licht van ver verwijderde sterrenstelsels altijd wel in meer of mindere mate intergalactisch gas en stof passeert en dan energie verliest. Je zou dan toch een aantal stelsels moeten zien die wel ‘geblurd’ zijn, vager dan normaal. Maar dat is dus niet het geval, vreemd eigenlijk. De roodverschuiving van sterrenstelsels zou een optelsom moeten zijn van kosmische roodverschuiving door de uitdijing van het heelal en roodverschuiving door astrofysische effecten. Het lijkt er nu echter op dat de roodverschuiving bijna 100% kosmisch van aard is. Die link werkt bij mij niet, krijg een ‘504 Gateway Time-out’.

Ik heb een keer ergens een artikel gelezen. De gemiddelde photon zou een “vrij pad” hebben van 10 miljard lichtjaar. Met enkele protonen per M3 in het vacuum, en de enorme afstanden tussen de sterren/stelsels, zou dat zomaar kunnen. Omdat we een maximale lichtreistijd hebben van 13,7 miljard jaar, merken we dus niet veel van de weinige photonen die onderweg sneuvelen. In ieder geval te weinig om “blurren” te kunnen detecteren.

Persoonlijk denk ik niet dat blurren het goede idee is. Dat zou betekenen dat een deel van de photonen wel aankomen en onderdeel van het waargenomen plaatje blijven, maar het blurren. Photonen die onderweg materie tegenkomen worden natuurlijk zo erg van richting veranderd dat ze gewoon uit het “plaatje” verdwijnen. Ze maken er dan geen deel meer van uit. Het is volgens mij wel een probleem met de afstandsmetingen van b.v. supernova’s en cepheids…stel dat 10% van de photonen (van een object ver weg) onderweg sneuvelen, de waarnemer ontvangt dan slechts 90% van de uitgezonden photonen van de bron. Dus de waargenomen “helderheid” van het object is niet correct. En dan is de berekende oorspronkelijke of echte helderheid van het object ook niet correct. En by the way….de waargenomen helderheid van b.v. een sterrenstelsel is ook een factor om de totale massa van dat stelsel te bepalen….maar ja, in hoeverre klopt dat als er onderweg meer photonen sneuvelen dan we verwachten?

De dichtheid van photonen is enorm. Ik kan me een tekst over fotografie herinneren. Als je buiten een foto maakt met je digitale camea, dan zou elke pixel iets van 60.000 photonen hebben gebruikt. Dus bij een 1-megapixel camera is de foto gemaakt met gebruik van 60.000 x 1.000.000 photonen.

Mooi om te lezen! Interessante theorie, dat tired-light. Op deze leek komt het wel over alsof het wat al te rap van de tafel wordt geveegd! Wat ik nergens terug vind, is dat de mens onmogelijk kan controleren hoe fotonen zich gedragen over de immense afstanden waar we het over hebben.

Wat mij opvalt aan het eerste punt, het onbreken van de blurring, is dat als men in acht neemt dat ook de ruimte tussen de materie in het universum geen perfect vacuüm betreft, er toch altijd blurring zou moeten zijn?

Het tweede punt, het optreden van tijdilatatie, is volgens mij ook geen reden tot uitsluiting van tired light, maar geeft aan dat er meer factoren zouden moeten spelen. Wellicht een combinatie van tired light en (http://alternatiefoerknaltheorie.nl/)?

Ook op het punt van microgolf achtergrond straling en behoud van energie zou het misschien kunnen zijn dat in dit gedeelte van het EMP er een onbekend effect hiervan de oorzaak is. Wellicht maakt een Higgs-Boson wel een duik in energie om de zoveel megaparsec. Goh wisten we het maar 🙂

Je hebt ook nog eens het probleem dat hoogenergetische kosmische straling, met name protonen, die door de ruimte reizen in theorie moeten reageren met de fotonen van de kosmische microgolf-achtergrondstraling en dat ze daardoor een maximum aan energie hebben, waar ze niet boven kunnen komen, de zogeheten Greisen-Zatsepin-Kuzmin (GZK) cutoff. Dus ook die interactie vindt onderweg naar de aarde plaats. Maar probleem is dat men wel degelijk kosmische straling tegenkomt met energieën bóven die limiet. Zie: http://www.astroblogs.nl/2015/05/16/waar-komt-die-extreem-energierijke-kosmische-straling-eigenlijk-vandaan/

Kan dat niet komen doordat de bron zich binnen de GZK-limiet bevind? Ook de gevonden concentratie aan het Grote Beer deel van de aardse sterrenhemel lijkt in die richting te wijzen dacht ik.

” Doordat de botsingskans toeneemt met de afstand, komt de energie van extragalactische kosmische straling die een afstand van meer dan 50 megaparsec (163 miljoen lichtjaar) aflegt tot de aarde niet meer boven de GZK-limiet uit. Deze afstand wordt de GZK-horizon genoemd. “

Ja dat zou een mogelijkheid kunnen zijn. Maar dan moet er wel binnen die straal een object zijn dat dergelijke deeltjes met zo’n absurd hoge energie kan produceren. Vast een zeer actief superzwaar zwart gat in een sterrenstelsel. Maar welke?

Hmmm, of een zwarte dwerg, gevormd door een onbekende anomaly! Wellicht lekt er een dimensie door een barrière heen… of de volgende fase van ‘sterren’, na het zwarte gat, compleet ondetecteerbaar in het emp 🙂 Nou jah zo kunnen we nog wel even doorgaan. Leuk!

Arie, wanneer je een beetje naar beneden scrolt, vind je het artikel dat ik linkte.

http://www.rationalskepticism.org/pseudoscience/the-2011-of-the-nobel-prize-for-physics-is-a-mistake-t26290-100.html

En ik ben het met je eens. De vraag die kosmologen zich moeten stellen is: Waarom zien we geen geblurrede lichtbronnen?

Mies.

En om het nog ingewikkelder te maken: net als de Hubble constante is het ook niet zeker of de lichtsnelheid echt zo constant is als algemeen wordt aangenomen: https://www.scientias.nl/de-lichtsnelheid-niet-zo-constant/

En daarmee kunnen weer veel, heel veel theorien omvallen.

Dat gaat over de “group velocity” van licht. Je kan net zo makkelijk artikelen vinden die gaan over de “group velocity” waarbij de lichtsnelheid hoger ligt dan “C’. Ik ken de details niet, maar volgens mij is dit gebeuren niet van invloed op astronomie, cosmologie en het gebruik van “C’ als een constante.

Why is light slower in glass? – Sixty Symbols https://www.youtube.com/watch?v=CiHN0ZWE5bk

(ik doel op het stukje op10:05 minuut en verder)

Als C niet constant zou zijn heeft dat volgens mij wel heel veel invloed op de astronomie hoor. We kijken immers terug in de tijd, en die tijd is direkt afhankelijk van C. Ofwel bejaard licht hoeft toch niet zo heel bejaard te zijn als algemeen wordt aangenomen….

En in een andere thread had ik al iets geschreven over de relativiteits theory, en dat de algemene aanname dat de relativiteits theorie van einstein perfect in overeenstemming is met de experimenten en observaties, niet helemaal juist is. Dwz. er zijn alternatieve verklaringen die hetzelfde verklaren (hetzelfde meetresultaat bevestigen), maar op andere aannamen zijn gebaseerd dan die van Einstein.

In één van deze artikelen wordt uitgelegd dat we dan welliswaar in elk inertieel referentie systeem een berekening doen van de lichtsnelheid die voor elk IRS gelijk is, maar dat is een wiskundige waarheid, en niet noodzakelijk een fysieke waarheid.

Zie bijv. het artikel wat nader ingaat op het Sagnac effect:

http://www.conspiracyoflight.com/SagnacRel/SagnacandRel.html